Als SSD vor inzwischen weit über zehn Jahren salonfähig wurden, da zögerten viele Anwender weiterhin ihre altbekannte und berechenbare Festplatte/Hard-Disk-Drive gegen einen Solid-State-Drive zu ersetzen.

Inzwischen erfährt jedoch jeder Besitzer eines Endgerätes, in dem eine SSD steckt, unmittelbar wie viel schneller ein Notebook oder PC, sich mit dieser Technik anfühlt. Schließlich ist die Arbeitsgeschwindigkeit eines Computers, auch wenn nicht oft in diesem Zusammenhang erwähnt, mitverantwortlich für eine angemessene Ergonomie. Man denke an lange und hemmende Ladezeiten von genutzten Anwendungen.

Die Geschwindigkeit

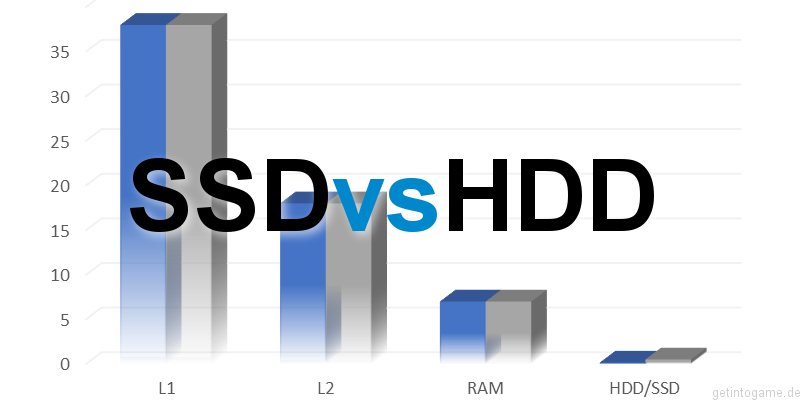

Die schnellste Komponente eines Computers ist der Prozessor. Dieser beheimatet weiterhin verschiedene Level an flüchtigem Speicher. Bspw. dem Level 1 Cache, der sehr nah an der CPU sitzt und die höchsten Datenrate an flüchtigem Speicher besitzt. In den meisten Fällen, wird bis zu Level 3, dieser schnellen Puffer-Speicher verbaut. In seltenen Fällen, kam auch schon ein L4-Cache zum Einsatz. Dieser jedoch für spezielle Anwendungen, wie die direkte Anbindung einer, im Prozessor integrierten Grafikeinheit.

Weiterhin ist der Arbeitsspeicher relativ nahe an den Prozessor angebunden. Der Datendurchsatz sinkt immer mehr, je weiter wir uns vom Prozessor entfernen, jedoch birkt handelsüblicher Arbeitsspeicher RAM (Random-Access-Memory) auch noch enorme Datendurchsatzraten im Bereich zweistelliger Gigabytes pro Sekunde. Beide Komponeten, der Cache im Prozessor, sowie der RAM, haben gemeinsam, dass sie auf Flash-Speicherzellen basieren. Also nanometer-großen Strukturen aus Halbleitern.

Kommen wir nun zum fast traurigen Ende dieser Datenverarbeitungskette, der Festplatte. Während die bisher beschriebenen Komponenten in der Lage sind, sowohl große als auch kleine Dateien und Operationen in hoher Geschwindigkeit, bis zu dreistelligen Gigabyte-Raten zu verarbeiten, sackt die herkömmliche Festplatte mit einem Mal auf einen Bruchteil dieser Werte ab.

Durch die Mechanik, die in den HDD verbaut ist, werden hohe Wartezeiten für den Zugriff auf die geforderten Daten erzeugt. Die Schreib-/Leseköpfe müssen warten, bis die Platter, die Magnetscheiben, auf denen sich die Datenblöcke befinden, an diesen vorbeibewegen. Etwa vergleichbar mit dem Lesevorgang einer CD, die von dem nötigen Laser abgetastet wird. Dieser muss ebenso abwarten, bis der entsprechende Ort, der die Daten bereithält, zur Verfügung steht. Wie etwa bei einem Radumlauf, sind auch hier die Außenbereiche schneller abzutasten, als die inneren Bereiche, sodass der Datendurchsatz auch aus diesem Grund nicht konstant sein kann.

Mit dem bereits erwähnten Bruchteil der Werte des Datendurchsatzes, ergibt sich also eine Kluft von zehntausenden Megabytes auf seiten der flüchtigen Puffer-Speicher und teilweise wenigen Kilobyte Transferrate auf Seiten des Fest-Speichers, der HDD.

Riesige Diskrepanz zwischen Flash-Speicher und Fest-Speicher Datendurchsätzen

Kein Wunder also, dass die reine Anwendungserfahrung stark unter diesem Abfall an Geschwindigkeit leidet.

Diesem Verhalten wirkt die inzwischen bewährte Technik der SSD vehement entgegen. Während HDD selbst bei sequenziellen Lese-Operationen nur auf wenige Hundert Megabyte/s Bereich kommen, landen SSD mit inzwischen bis zu 3500 MB/s einen Volltreffer um dieses Nadelöhr zu beseitigen.

Die Geschwindigkeit der SSD beruht auch auf dem Vorteil von schnellem Flash-Speicher und lassen die Geschwindigkeitsnachteile schwinden.

Die einzelnen Speicherzellen der SSD werden Parallel gelesen und geschrieben, sodass nicht nur bei reinem Kopieren, bzw. Schreiben von Daten dieser Geschwindigkeitsvorteil entsteht, sondern auch die Zugriffszeiten minimiert werden. Von unter Umständen hunderten Millisekunden bei HDD, auf einen Bruchteil nach dem Komma, bei SSD.

Der subjektiv empfundene Geschwindigkeitsvorteil ist immens. So verringern sich Ladezeiten des gesamten Betriebssystems auf ein Minium gegenüber Festplattenladezeiten und auch Programme starten erheblich schneller. Mal abgesehen von Transferlastigen Anwendungen wie Videoschnittapplikationen oder Datenbankanwendungen mit ihren vielen kleinen und parallelen Abfragen, bei denen SSD umso mehr im Vorteil sind.

Haltbarkeit

Auch bei SSDs gilt, wie meist im Elektronikbereich: Die Qualität skaliert mit dem Preis. Insbesondere Modelle von Samsung überstehen im Laufe der Nutzungszeit Schreibvorgänge im Petabyte-Bereich, bevor diese erste Fehler bis hin zum Totalausfall zeigen. Zum Vergleich: Ich nutze seit acht Jahren meine Samsung 850 Pro SSD in einem Lenovo Notebook intensiv und habe erst ein Zehntel der potentiell möglichen Haltbarkeit ausgereizt; also 100 Terabyte an Datenumsatz absolut.

Schnittstellen

Die erwähnten 3500MB/s, erreichen SSD nur mit aktuellem M.2 Anschluss über NVMe, der per PCI-Express BUS elektrisch angebunden ist. Normalerweise sollten inzwischen alle aktuellen Notebooks, sowie PC über diesen Anschluss verfügen. Jedoch gilt trotzdem Vorsicht, da es weiterhin Modelle gibt, die den M.2 Anschluss lediglich mit einem SATA 6G BUS über AHCI anbinden. In diesem Fall sind wie bei SSD im bekannten 2,5″ Format lediglich Transferraten um die max. 550 MB/s zu erwarten.

Einfach zu unterscheiden sind die im Platinen-Design gehaltenen M.2 SSD gegenüber dem herkömmlichen Barren-Design von SATA-SSDs.

Datenrettung

Bei einem Defekt jedoch, gestaltet sich eine mögliche Datenrettung unter Umständen kostspieliger als bei einer herkömmlichen HDD. Entsprechend gilt auch beim Einsatz einer SSD, dass sinnvoll getaktete Backup-Vorgänge immer wertvoll sein können.

Schlussendlich hat die Anwendergemeinde mit der SSD-Technik, den so lange hinzunehmenden Flaschenhals einer Mechanischen Festspeichertechnik überwunden und man kann sich in Sachen Geschwindigkeit, einer ins positive gesteigerten Bedienererfahrung erfreuen.